Umfrage zur Systemgenauigkeit, durchgeführt im Januar 2025

4. Januar 2025|M9 STUDIO INC. Forschung

1. Einführung

1.1 Zweck des Berichts

Das letzte Mal, dass wir die Genauigkeit von KI-Übersetzungen untersucht haben, war im August 2024. In diesem Bericht berichten wir über die neuesten Ergebnisse zur Übersetzungsgenauigkeit vom 4. Januar 2025 untersuchen umfassend die Entwicklung und Probleme von Videoübersetzungssoftware im Zeitraum von August 2024 bis Januar 2025.

Darüber hinaus werden wir durch den Nachweis der Überlegenheit unseres M9 STUDIO umfassende Qualitätsindikatoren präsentieren, die auf dem Markt erforderlich sind .

1.2 Umfang und Ziel der Überprüfung

- Verifizierungszielsoftware:

- Heygen

- RASK

- Elflabs

- WAVE A.I.

- Synthese

- Unser Unternehmen M9 STUDIO (ausführliche Analyse im letzten Kapitel)

- Details zur Implementierung:

- Englisch→Japanisch (Englisch-Japanisch) : 3 Sprecher: Mutter, Vater und Hauptfigur (Tochter)

- Japanisch→Englisch (Japanisch-Englisch) : Erzählung von einem englischen Sprecher

- Bewertungsachse : Übersetzungsgenauigkeit (gemessen mit der Gemini-Version vom Januar 2025), Videoperfektion (Audio-/Videosynchronisation, Sprecherzuordnung, Aussprachequalität usw.)

Zur Verifizierung verwendetes Video

Alle zur Überprüfung verwendeten Videos sind unter Creative Commons (lizenzfrei) lizenziert (kommerzielle Nutzung möglich). Das japanische Video wurde von der Konsularabteilung der Abteilung für öffentliche Angelegenheiten und Kulturaustausch der US-Botschaft produziert (Link) . Das englischsprachige Video wurde vom Sussex Humanities Lab (Link) produziert .

CC: Lizenz: Public Domain Dedication

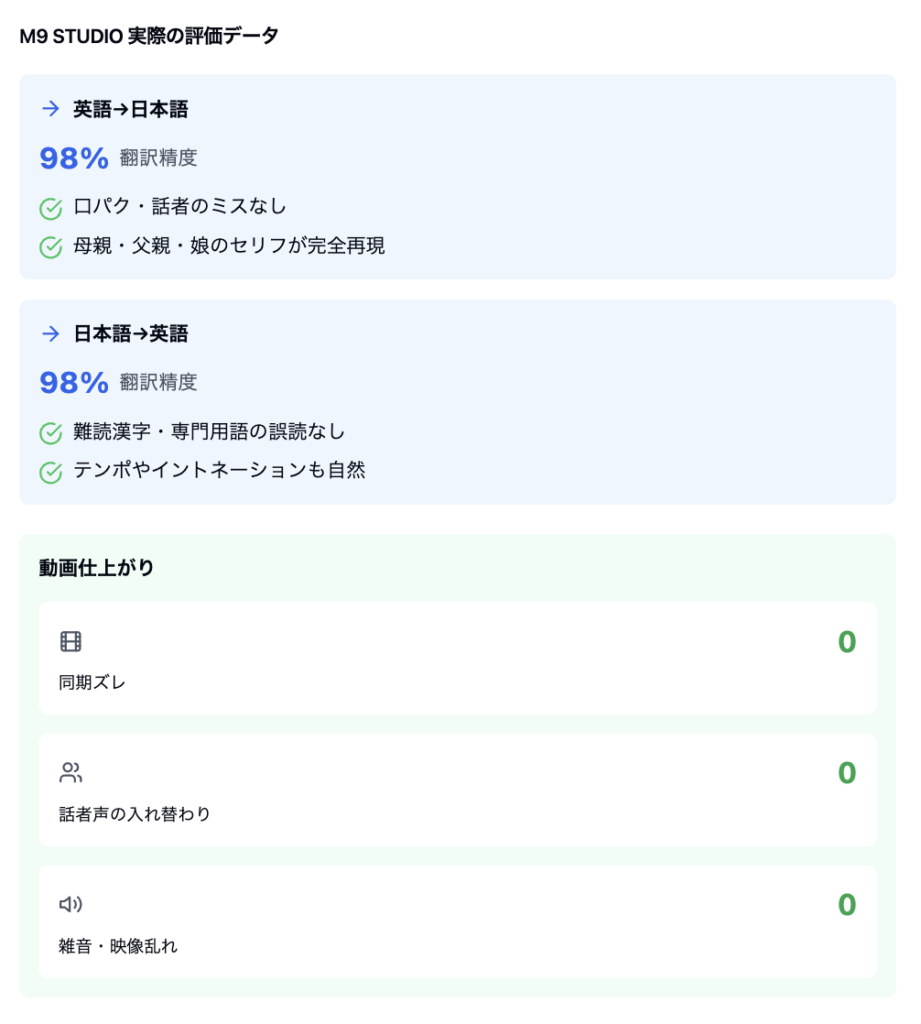

Übersetzungsergebnisse mit dem M9 STUDIO-System

[Übersetzungsgenauigkeit] Erreicht eine hohe Genauigkeit von über 98 % auf praktischem Niveau und sorgt für eine stabile Übersetzungsqualität sowohl bei Englisch-Japanisch- als auch bei Japanisch-Englisch-Übersetzungen. Insbesondere eignet es sich hervorragend für das Verständnis von Kontexten und die Wiedergabe natürlicher Phrasen und ist für den geschäftlichen Einsatz sehr gut geeignet.

[Hauptmerkmale]

Integrierte multimodale Architektur

Durch die Übernahme eines Designkonzepts, das Übersetzungs-Audiosynthese und Videosynchronisation integriert, arbeiten alle Elemente harmonisch miteinander. Dadurch kann die verbesserte Übersetzungsgenauigkeit insgesamt eine hohe Ausgabequalität gewährleisten, ohne die Leistung anderer Elemente zu beeinträchtigen.

Intelligentes Sprechererkennungssystem

Ein einzigartig entwickelter KI-Algorithmus erfasst die Eigenschaften mehrerer Charaktere genau und behält die Eigenschaften der Stimmqualität und des Sprechstils jedes Charakters bei. Beispielsweise wird in einer Familiengesprächsszene ein natürlicher Dialog reproduziert, ohne die Individualität der Stimmen von Mutter, Vater und Tochter zu beeinträchtigen.

Zweisprachige Sprachgenerierungs-Engine

Wir haben sowohl in Japanisch als auch in Englisch eine Aussprachequalität auf muttersprachlichem Niveau erreicht. Insbesondere auf Japanisch können Fremdwörter wie „Daten“ und „Computer“ sowie komplexe Kanji gelesen werden, wodurch eine problemlose Audioausgabe möglich ist.

Hochpräzises Videosynchronisationssystem

Überprüft automatisch die Synchronisierung von Mundbewegungen und Audio auf Bildebene, um Fehlausrichtungen und Probleme mit der Audioqualität proaktiv zu erkennen und zu korrigieren. Durch die Kombination automatischer Kontrollen mit KI und detaillierter Kontrollen durch Menschen erreichen wir ein Höchstmaß an Qualitätskontrolle.

Detaillierte Verifizierungsergebnisse der Software anderer Unternehmen

Hier habe ich versucht, ein Video unter genau den gleichen Bedingungen mit einem Videoübersetzungstool zu übersetzen, das weltweit eine große Verbreitung hat.

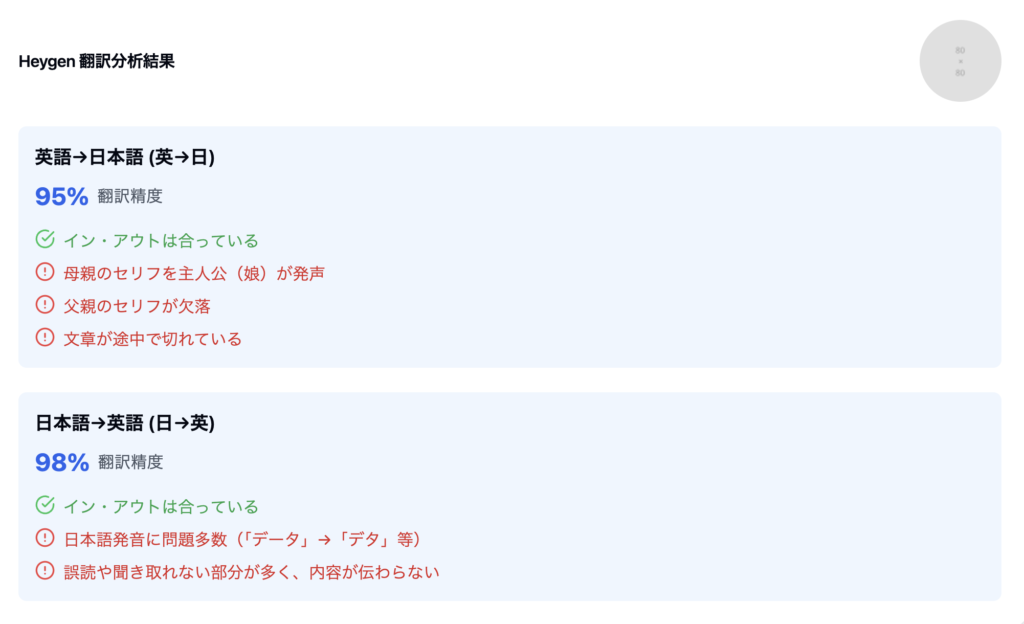

2-1

Hauptthemen

- Englisch → Japanisch : Die Sprecherzuordnung ist gestört, z. B. wenn die Tochter den Text der Mutter spricht und der Text des Vaters unausgesprochen bleibt.

- Japanisch → Englisch : Es gibt viele Fehlinterpretationen von Kanji und gebrochene Grammatik, was es unklar macht, was gesagt wird.

Gesamtbewertung : Obwohl die Textgenauigkeit der Übersetzung hoch ist, gibt es Probleme mit der Sprecherverwaltung und der Aussprachequalität, und es gibt große Mängel bei der Qualität des Videos

2-2.RASK

2-3.Elevenlabs

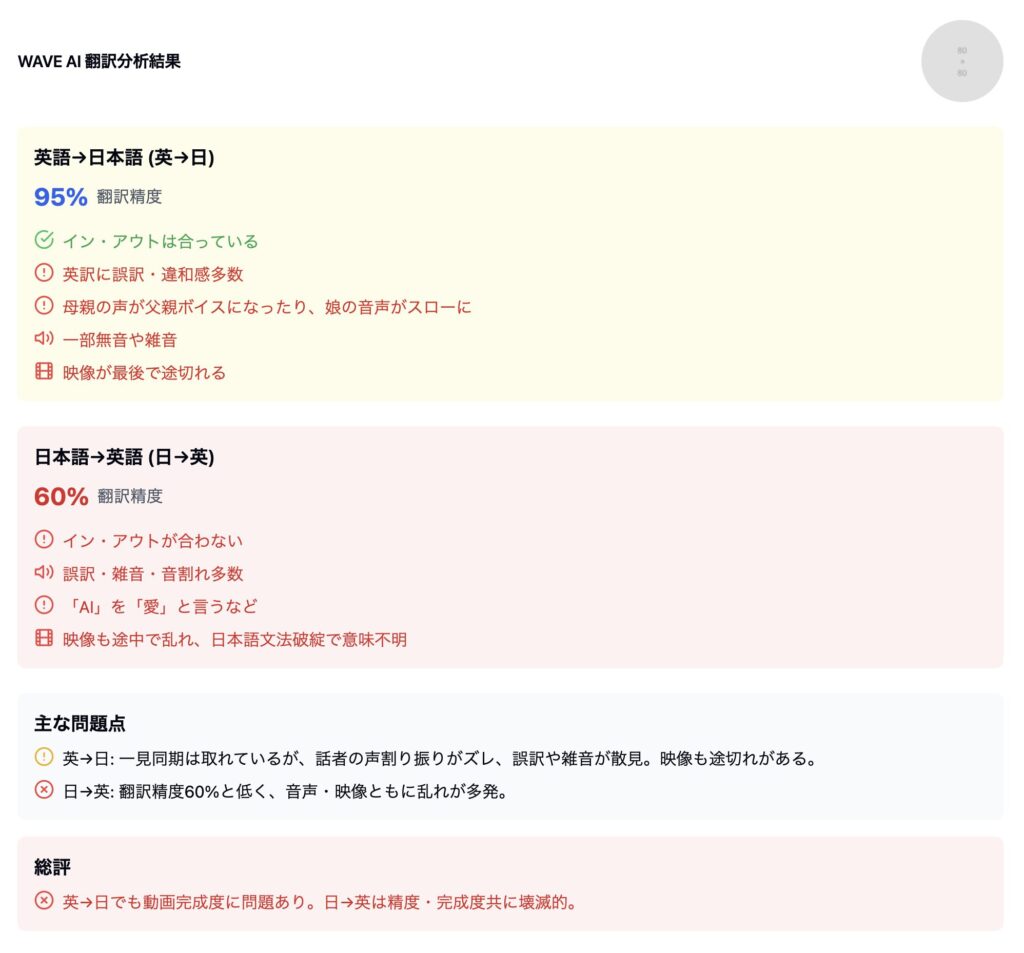

2-4. WAVE AI

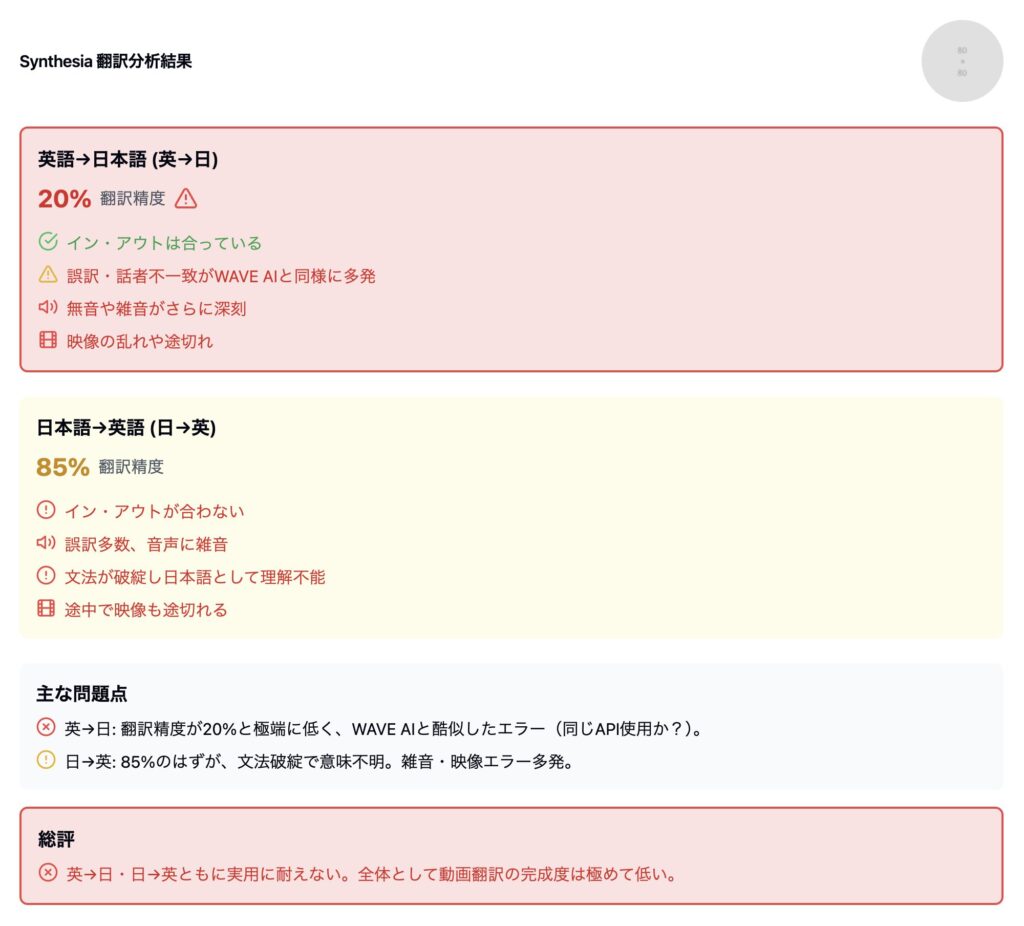

2-5. Synthese

3. Unser Unternehmen: M9 STUDIO-Verifizierungsergebnisse

Das Folgende ist das Ergebnis der Übersetzung eines Videos mit unserem System.

Basierend auf dem fertigen Video haben wir die neueste Version von Vertex verwendet, um die Genauigkeit und Gesamtbewertung zu ermitteln, ähnlich wie bei den Produkten anderer Unternehmen.

Hauptmerkmale des M9-Systems

- Konsistenz im multimodalen Design

- Schon in den frühen Entwicklungsstadien wurde die Architektur auf der Grundlage der Dreieinigkeit von „Übersetzung“, „Sprachsynthese“ und „Videosynchronisation“ aufgebaut.

- Wir haben ein System zur integrierten Verwaltung des gesamten Prozesses , sodass die Videoseite auch dann nicht ausfällt, wenn wir die Übersetzungsgenauigkeit verbessern

- Hochpräzise Lautsprecheridentifikation/Lautsprecherumschaltung

- Ein einzigartiger Algorithmus analysiert die Zeichen und passt automatisch die richtige Sprachqualität und das richtige Timing

- Die Sprechgeschwindigkeit und Intonation von Müttern, Vätern und Töchtern wird individuell optimiert.

- Muttersprachliche Aussprachesynthese für Japanisch und Englisch

- Lernt automatisch spezielle Aussprachen wie „Daten“ und „Computer“, um eine natürliche und korrekte Lesung

- Es ist auch gut darin, Kanji zu lesen und Grammatik zu verarbeiten, was das Aufschlüsseln erschwert.

- Automatisieren Sie den Synchronisationstest mit Video

- Wir überprüfen die Lippen- und Audiosynchronisation Bild für Bild, Verzögerungen, Stille und Rauschen auf nahezu 0 zu reduzieren.

- Hohe Qualität wird durch eine Mischung aus KI-Verifizierung und menschlicher Verifizierung gewährleistet.

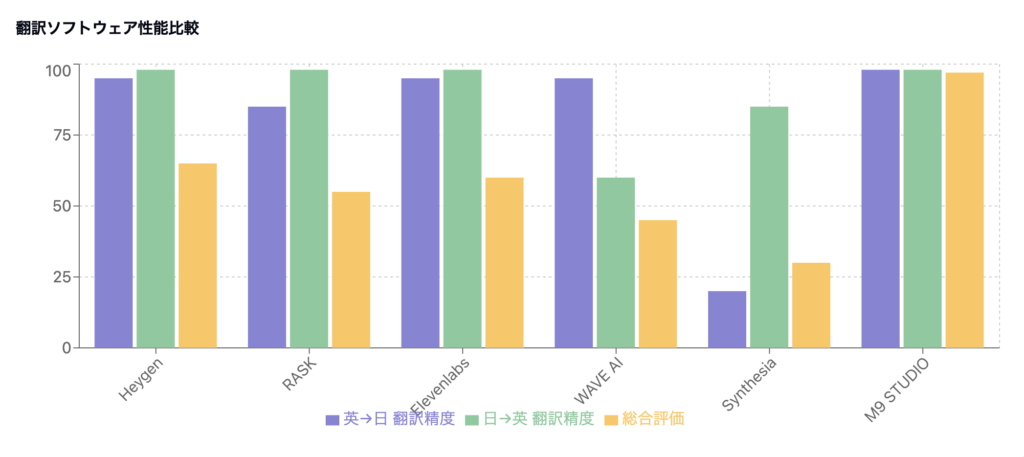

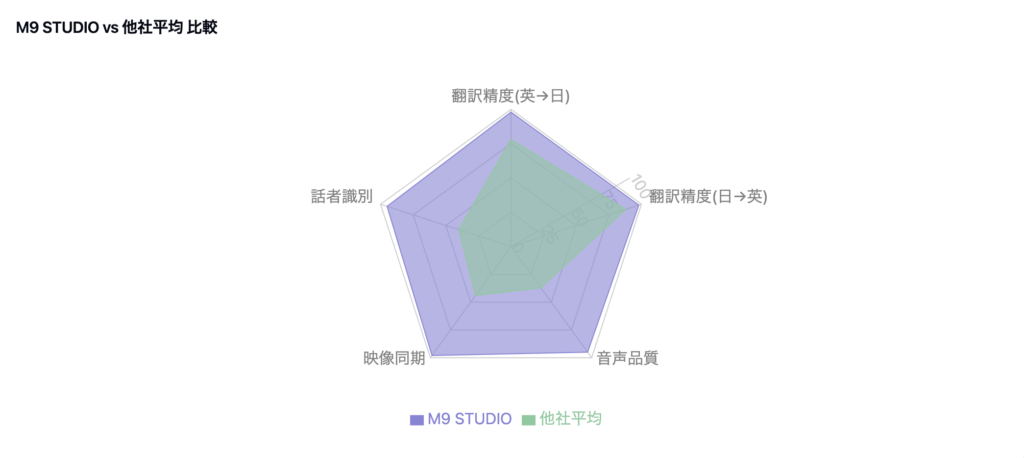

Gesamtvergleichstabelle

Basierend auf den bisherigen Ergebnissen haben wir das System jedes Unternehmens zusammengefasst und umfassend bewertet.

Hinweis : „Übersetzungsgenauigkeit“ ist ein umfassender Index, der Zwillingszahlen + tatsächliche Sprachkompatibilität kombiniert.

„Video-Vollständigkeit“ ist eine umfassende Bewertung der Sprecherzuordnung, der Qualität der Sprachsynthese, der Videostörung/-längenabweichung usw.

4. Technische Änderungen in der KI-Branche von August 2024 bis Januar 2025

4.1 Schnelle Steigerung der Übersetzungsgenauigkeit

- Stand August 2024 : Die durchschnittliche Übersetzungsgenauigkeit jedes Unternehmens beträgt etwa 85 % (oberste 90–95 %).

- Stand Januar 2025: Die meisten Produkte erreichen 95–98 %

Ursachenanalyse

- Integration großer Sprachmodelle

- Eine neue KI-Engine (z. B. Gemini) wurde eingeführt, die die Genauigkeit der zeichenbasierten Übersetzung erheblich verbessert.

- Betonung der Genauigkeit aufgrund des Wettbewerbsdrucks

- Da die Übersetzungsgenauigkeit tendenziell ein Indikator für die Marktbewertung ist, wurde der Entwicklung Priorität eingeräumt , die die „Zahlen“ kurzfristig erhöhen würde

4.2 Verschlechterung der Videoqualität

- Es gibt viele fatale Fehler, wie zum Beispiel, dass die Hauptfigur den Text der Mutter spricht und der Text des Vaters weggelassen wird.

- von Japanisch aufgrund falscher Aussprache (z. B. „Daten“ → „Daten“)

- Videolänge und Audio-Timing stimmen nicht überein, Rauschen und Knacken nehmen zu

Typisches Beispiel: Fall eines berühmten ausländischen Übersetzungssystems

- August 2024 : Übersetzungsgenauigkeit 90–95 %, Video selbst hatte wenige Probleme

- Januar 2025: Übersetzungsgenauigkeit auf 98 % erhöht

- jedoch zu einem schwerwiegenden Synchronisationsfehler, bei dem die Hauptfigur den Text der Mutter aussprach.

- Im Gegenzug für eine verbesserte Übersetzungsgenauigkeit sinkt die Videoqualität erheblich

Hintergrund des Kompromisses

- Während die Sprachverarbeitungsmodelle gestärkt wurden die Verbesserungen der Funktionen zur Steuerung der Spracherzeugung, Sprecheridentifikation und Videosynchronisation

- Der typische Kompromiss zwischen „Korrektheit auf Zeichenebene“ und „multimodaler Vollständigkeit“

5. Strukturelle Probleme der Software jedes Unternehmens

finden Sie eine Zusammenfassung der Hauptprobleme, die bei den Produkten anderer Unternehmen im Januar 2025 festgestellt wurden

5.1 Fehler bei der Sprechererkennung

- Dies macht sich vor allem in Fällen mit drei Sprechern bemerkbar, etwa wenn die Tochter den Text der Mutter spricht

- Es gibt viele Fälle, in denen der Text des Vaters fehlt oder mit der Stimme der Hauptfigur vorgetragen wird.

- Ursache : Unzureichender Sprecherverwaltungsalgorithmus und unzureichendes Verknüpfungsdesign mit der Sprachsynthese-Engine.

5.2 Verschlechterung der Sprachqualität

- Fehler in der japanischen Aussprache : „data“ → „data“, Fehlinterpretation von Kanji usw.

- Unregelmäßige Schwankungen der Sprechgeschwindigkeit (plötzlicher Übergang von langsam zu schnell)

- Erhöhte Stille und Lärm, Zeitverzögerung beim Video

- Ursache : Japanische Leselogik und Geschwindigkeits-/Intonationssteuerung sind unausgereift.

5.3 Architekturtrennung

- Viele Unternehmen getrennt entwickeln

- Aufgrund späterer Koordinierungsversuche kommt es zu Dateninkonsistenzen zwischen Modulen

- die neueste Version eines umfangreichen Sprachmodells , steigt das Risiko von Inkonsistenzen bei der Sprachsynthese und Videosynchronisation.

5.4 Unzureichende Qualitätskontrolle/-prüfung

- des Verifizierungsprozesses auf die Übersetzungsgenauigkeit (Zahlen) konzentriert und die eigentliche Prüfung der Videoqualität aufgeschoben haben

- Die erweiterte Sprechererkennung und die japanische Aussprache wurden ohne Tests auf tatsächlichen Geräten veröffentlicht und Probleme wurden erst entdeckt, nachdem Feedback von Benutzern eingegangen war

6. Detaillierte Analyse technischer Probleme

6.1 Einschränkungen der multimodalen Verarbeitung

- Da sich die Übersetzungsgenauigkeit verbessert hat, ist die Anzahl der Wörter und Sätze gestiegen und die Ausdrücke sind natürlicher geworden, aber die Längenanpassung der Videos hat nicht mitgehalten.

- Wenn der Ausgabetext eines groß angelegten Modells unverändert für synthetisierte Sprache verwendet wird, kommt es zu deutlichen Diskrepanzen bei der Sprechzeit und der Lippensynchronisation

6.2 Mängel bei der Sprecherbelegung

- Bei drei oder mehr Sprechern können bestehende Algorithmen nicht genau verfolgen, welche Person welche Zeile spricht .

- Da Bilderkennung, Spracherkennung und Übersetzung nicht zusammenarbeiten, kommt es zu Verwirrung, etwa wenn die Stimme der Tochter abgespielt wird, obwohl die Mutter im Bild ist

6.3 Sprachverarbeitung speziell für Japanisch

- englischsprachige Unternehmen gibt

- Falsche Aussprachen wie „Daten“ können auf Verwirrung bei der Verarbeitung von Wörtern wie „Daten“ und „Delta“ innerhalb des Systems zurückzuführen sein.

7. Warum ist die Technologie von M9 STUDIO so leistungsstark?

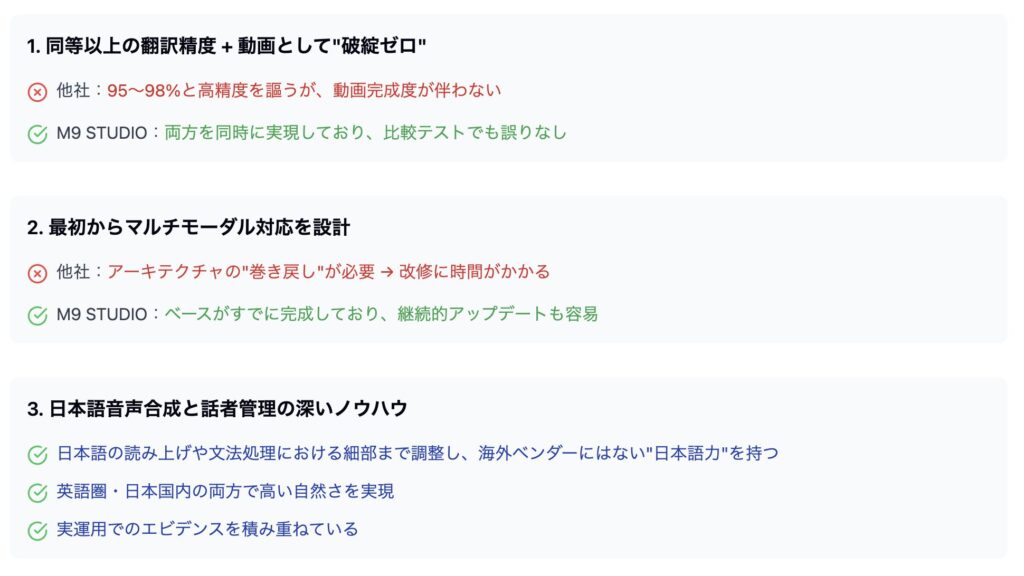

In unserem Unternehmen betreiben wir täglich Forschung und Entwicklung und aktualisieren unsere Produkte . Dadurch ist es möglich, die Übersetzungsgenauigkeit zu verbessern, ohne von externen APIs oder KI-Engines beeinflusst zu werden

Die Dienste vieler anderer Unternehmen sind gezwungen, als Reaktion auf Änderungen in den Spezifikationen wichtiger KI-Modelle oder APIs „zurückzuspulen“ oder umfangreiche Renovierungen vorzunehmen, aber M9 STUDIO verwaltet die Kernlogik und Algorithmen intern , sodass kurze Zeit Mit können Sie eine kontinuierliche Abstimmung durchführen Daraus ergibt sich

- Erforderliche neue Funktionen und Genauigkeitsverbesserungen werden sofort berücksichtigt

- Sorgt für stabile Qualität und Videosynchronisation

- Benutzerfeedback schnell

Vorteile wie dieser werden entstehen.

Einer der Hauptgründe, warum M9 STUDIO als eines der Besten gilt, in der Lage ist, ständig die neueste KI-Technologie zu integrieren und eine einzigartige Weiterentwicklung zu erreichen ohne die „Perfektion des Videos“ zu opfern.

Memo|Gibt es weniger Misserfolge in Spanisch und Französisch?

Englisch → Spanisch (oder Englisch → Französisch/Englisch → Chinesisch) wird jedoch

Der Grund dafür ist, dass sich englischsprachige Entwicklungsunternehmen häufig auf die Entwicklung und Abstimmung von Englisch⇔Spanisch/Englisch⇔Französisch/Englisch⇔Chinesisch (Antworten auf) konzentrieren, was dazu führt, dass unnatürliche Übersetzungen und Sprachsynthesen auftreten Japaner kommen in der Regel vor.

Grund, warum Übersetzungen zwischen Japanisch und Fremdsprachen scheitern, ist, dass Englisch und viele europäische Sprachen Ähnlichkeiten in der Wortreihenfolge und Satzstruktur , was es einfach macht, sich selbst mit groß angelegten Modellen zu übersetzen Das japanische Modell kann dies nicht vollständig berücksichtigen, da die grammatikalische Struktur des Japanischen sehr unterschiedlich ist, beispielsweise das Subjekt weggelassen wird und sich die Nuancen je nach Partikel stark ändern .

8. Vorteile unseres Systems

8.1 Integriertes architektonisches Design

- Übersetzung → Audio → Video wird eines konsistenten Qualitätskontrollsystems .

- Überprüft die Konsistenz in Echtzeit und führt die Synchronisierungsverwaltung Frame für Frame durch.

- Ab August 2024 unsere synthetischen Sprach- und Sprechermanagementmodule weiter stärken

8.2 Präzise Steuerung der Sprecheridentifikationstechnologie

- Szenarien und Stimmen werden vorab mithilfe einzigartig entwickelten Algorithmus

- individuell optimierte Sprachsynthese-Engines zugewiesen werden, kommt es fast nie zu Fehlern wie Zeilensalat.

7.3 Umfangreiche Unterstützung für Japanisch

- der japanischspezifischen Aussprache (lange Laute, Konsonanten, spezielle Lesarten usw.).

- Wir verwenden unser eigenes Wörterbuch und Akzentwörterbuch, um Wörter wie „Daten“ und „Computer“ richtig zu unterscheiden.

- Während die Übersetzungsgenauigkeit sowohl für Englisch als auch für Japanisch ist auch die Qualität der Sprachäußerungen hoch .

8.4 Nachweise für die praktische Anwendung

- Die Genauigkeitsüberprüfung mit der neuesten Version von Vertex aus dem Jahr 2025 ergab außerdem die Bewertung „so natürlich wie eine Muttersprache“ und „keine Fehlzuordnung mehrerer Sprecher“.

- Da das Produkt sehr vollständig ist, keine „Rückwärtsentwicklung“ erforderlich und das Risiko eines Fehlers bei jedem Update ist gering.

Memo|Probleme bei Softwareeinführungsfällen im Ausland

In den letzten Jahren haben einige japanische Unternehmen und Dienste ausländische Software eingeführt , die einen hohen Anteil an Videoübersetzungsdiensten auf dem Weltmarkt hat

Einige japanische Dienste und Unternehmen verwenden beispielsweise eine bestimmte berühmte Übersetzungs-API. Wie die Ergebnisse dieser Überprüfung zeigen, gab es jedoch schwerwiegende Probleme bei der Erstellung übersetzter Videos auf Japanisch (gemischte Sprecherzuordnungen, fehlerhafte Aussprache/Grammatik usw.) und das

Die KI-Entwicklung japanischer Unternehmen stützt sich häufig auf umfangreiche Sprachmodelle und Sprachtechnologien aus dem Ausland. jedoch klar geworden, Qualitätsmängel wie dieser unvermeidlich sind, die für das Japanische typische Verarbeitung von Aussprache und Grammatik

In dieser Hinsicht glauben wir, dass unsere Technologie, die auf Japanisch eine hohe Genauigkeit und hohe Qualität erreichen kann

9. Zukunftsaussichten und Auswirkungen auf den Markt

Wie Sie anhand dieser Daten sehen können, ist es für andere Unternehmen derselben Branche schwierig, aufzuholen, nachdem sie viel Zeit und Geld in die Entwicklung investiert haben. Wir werden weiter über die aktuelle Situation berichten, warum dies so ist.

9.1 Möglichkeit des Comebacks durch andere Unternehmen

- Eine grundlegende Neugestaltung (architektonische Umstrukturierung) ist erforderlich.

- End-to-End-Verbesserungen Bereichen „Übersetzung“, „Sprachsynthese“, „Videosynchronisierung“ und „Sprecherverwaltung“ erfordern erhebliche Ressourcen und Zeit.

- selbst bei einer hybriden Modifikation nur schwer zu lösen sein wird .

9.2 Steigende Qualitätsanforderungen

- Während die Nachfrage nach Videoübersetzungen auf dem Markt steigt, beginnen die Benutzer zu erkennen, dass „eine hohe Übersetzungsgenauigkeit allein nicht ausreicht“.

- die Nachfrage nach Gesamtqualität wie natürlichem Audio, Videosynchronisation und Lautsprecheranpassung

9.3 Wert von M9 STUDIO

- Hochwertige Endprodukte steigern die Zufriedenheit der Endbenutzer und das Markenvertrauen (derzeit gibt es keine Videoübersetzungstools, die unser Niveau übertreffen).

- der Aufwand für nachträgliche Änderungen entfällt , werden Betriebskosten und Supportkosten reduziert.

- Da sich groß angelegte KI-Modelle weiterentwickeln, flexible und stabile Updates möglich sein.

[Wichtig] Bezüglich der Sicherheit von KI-Videoübersetzungstools

Der Grund dafür, dass japanische Unternehmen KI nur langsam einführen, liegt darin, dass viele Unternehmen befürchten, dass ihre eigenen Daten als Lerninformationen für KI verwendet werden. es bestehen jedoch immer noch Bedenken, dass ein solches Datenlernen in im Ausland hergestellter Videoübersetzungssoftware verwendet werden könnte

Im Fall eines großen Unternehmens wie Panasonic führten sie beispielsweise Anthropic-Produkte ein ( am 8. Januar 2025 gaben sie auf der CES bekannt, dass sie eine strategische Vereinbarung getroffen hatten ), die das Problem des Lernens von Daten zu lösen scheinen Um Risiken zu vermeiden, kommt es darauf an, zu entscheiden, welche Art von KI eingesetzt werden soll.

*Anthropic wurde aufgrund von Bedenken hinsichtlich der Sicherheit von Open AI ( Materialien )

Mit dem KI-Videoübersetzungstool von M9 leiten wir Ihre Unternehmensinformationen oder -daten niemals

In unserem Unternehmen legen wir seit Beginn der Einführung von KI großen Wert auf dieses Thema und arbeiten nach strengen Richtlinien, die bei der Verarbeitung aller Daten, einschließlich Protokollen und Übersetzungsergebnissen, den Einsatz im Unternehmen voraussetzen.

Dateneinstellungen ohne Training

- Trennung der Trainingsdaten

Die von Ihnen hochgeladenen Videos und Untertitelinformationen werden nur für die Übersetzungsverarbeitung verwendet und nicht zum Neutraining oder zur Verbesserung der Leistung unserer KI-Modelle. - Opt-in

Wir haben keine „Opt-in“-Option, die es uns ermöglicht, zusätzliche Daten zu erfassen und für das Lernen zu verwenden, sodass keine Möglichkeit besteht, dass die Daten unbeabsichtigt verwendet werden.

Protokollaufbewahrungsrichtlinie

- Zugriffsbeschränkungen und Verschlüsselung

Basierend auf Sicherheitsstandards auf Unternehmensebene werden die interne Systemkommunikation und gespeicherte Daten immer verschlüsselt und die Zugriffsrechte sind begrenzt. - Minimale und strenge Verwaltung

Auch wenn es notwendig ist, Protokolle für Fehleranalysen usw. zu speichern, werden Protokolle zumindest für einen begrenzten Zeitraum aufbewahrt und sicher gelöscht, wenn sie nicht mehr benötigt werden.

Für Ihren Seelenfrieden

- Administratorrechte und Überwachungsprotokolle

Sie können Administratorrechte ausüben und Überwachungsprotokolle zum Nutzungsstatus überprüfen. Im unwahrscheinlichen Fall, dass es zu einem verdächtigen Zugriff kommt, können wir schnell reagieren. - Dediziertes Support-System

Von vor bis nach der Implementierung gehen unsere engagierten Support-Mitarbeiter ausführlich auf die Wünsche und Fragen Ihres Unternehmens ein und erläutern Ihnen jederzeit die Sicherheitsmaßnahmen.

Bei M9 konzipieren und betreiben wir unsere Dienste stets mit dem strikten Schutz der wichtigen Informationen unserer Kunden als oberste Priorität. Nutzen Sie gerne unser KI-Videoübersetzungstool.

Abschluss